實際嘗試使用DeepSeek API

突然造成關注的 DeepSeek

DeepSeek 是一家於2023年由中國私募基金「幻方量化」創立的人工智慧公司,專注於AI技術。算是少數專注於基底模型訓練的廠商。幻方量化這家公司的負責人很年輕,1985年生,才40歲,同時也是DeepSeek的創辦人。但他為何從投資領域跑來訓練AI模型? 如果對這家企業有興趣,可以參考這裡。)

從沒沒無聞到震動市場,主要是因為其最新成果 DeepSeek-V3 與 R1模型,採用「混合專家架構」設計,僅在需要時啟動部分「腦細胞」,以便於降低運算資源消耗。據傳,由於訓練該模型僅使用 2048 部 NVIDIA H800 GPU,耗時約兩個月,以極低的成本(約為560萬美元)完成訓練,但 R1 模型在數學和推理基準測試中表現出色,號稱與OpenAI的o1模型效果相當。

據聞 Meta 和 OpenAI 對 DeepSeek 的快速崛起感到緊張,主要原因在於 DeepSeek 在各種壓力底下,居然可以更低的成本,基於過去開源的基礎完成更高階的成果展現。Meta的首席AI科學家Yann LeCun指出,DeepSeek的成功證明了開源模型(例如他們家的llama)正在超越專有模型(像是 GPT or Gemini),強調了開放研究與開源的重要性。 總之這些進展引起了矽谷的關注,甚至有Meta員工匿名表示,內部出現了恐慌情緒,工程師們正在連夜嘗試複製DeepSeek的技術。

可預見的未來,模型(不管是雲端或地端)的可選擇性將會大增,在使用的成本上也有機會日漸低廉。因此,我們就來看看 DeepSeek API 的使用。

使用 DeepSeek API

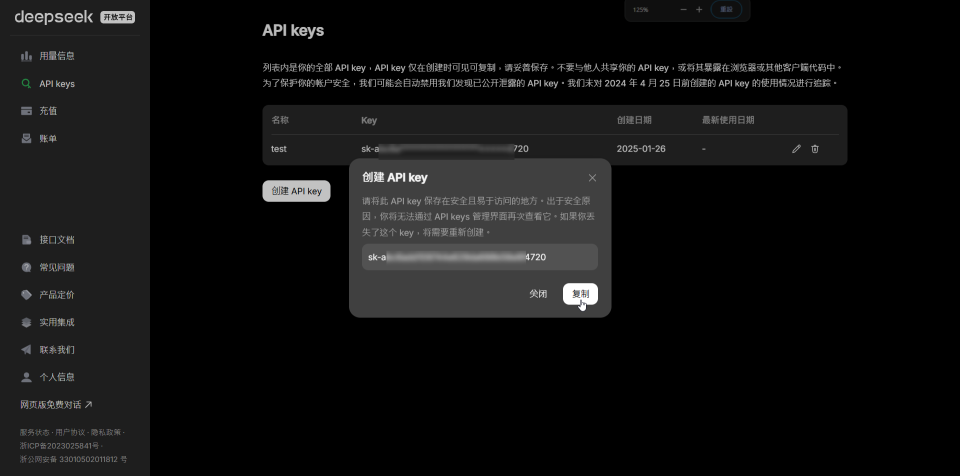

DeepSeek 也有提供雲端版本的API,要使用 DeepSeek 的 API,您需要先申請 API 金鑰(以信用卡或PayPal付費),位於這裡:

申請後,您可以透過發送 HTTP POST 請求與 DeepSeek 的模型進行互動。以下是使用 cURL 的範例:

curl https://api.deepseek.com/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer <DeepSeek API Key>" \

-d '{

"model": "deepseek-chat",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Hello!"}

],

"stream": false

}'

你會發現除了 API Endpoint 與 model 之外,其它與 OpenAI API呼叫幾乎完全相同。

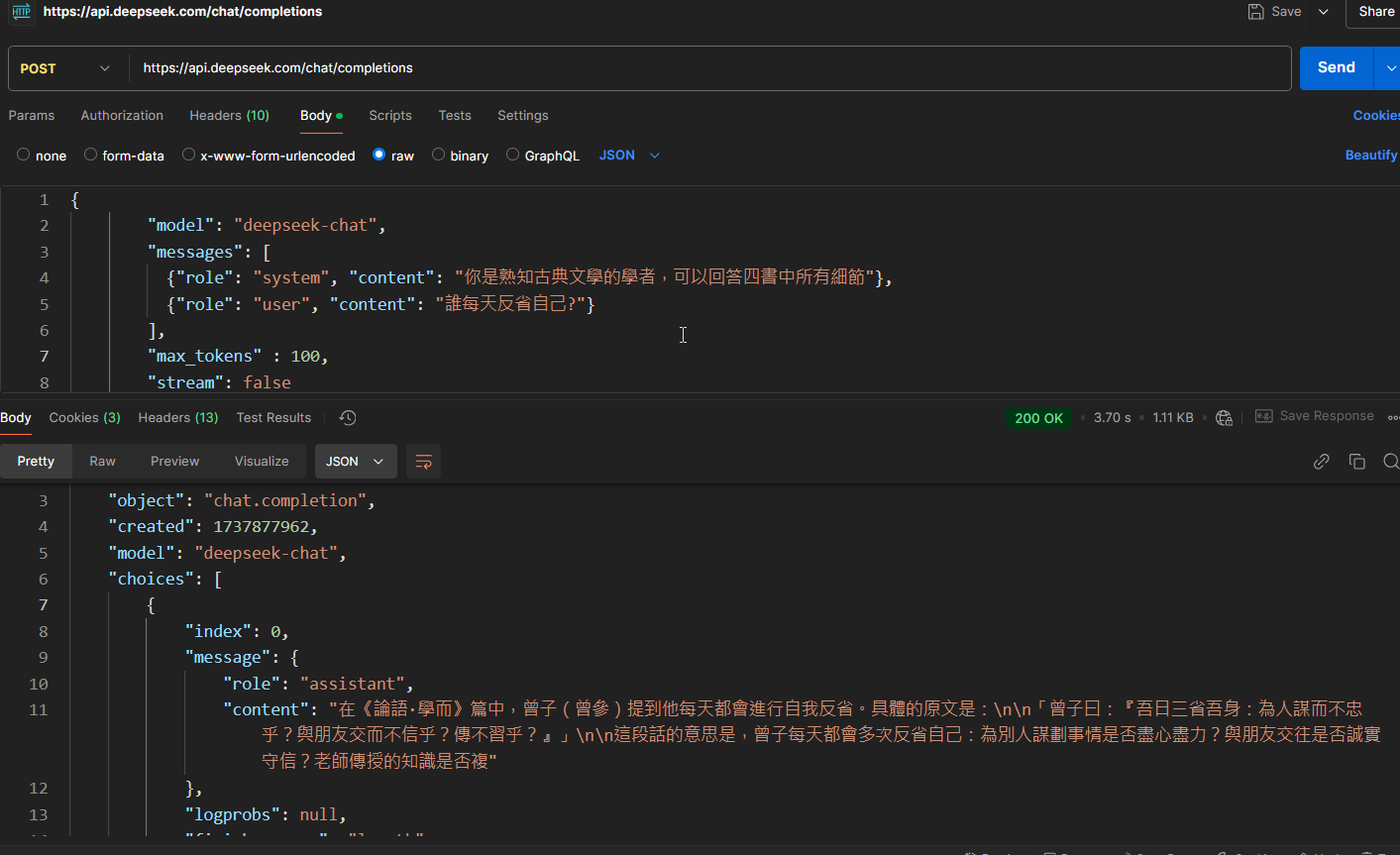

底下是使用postman呼叫deepseek-chat model的例子:

實際嘗試,不管是基本的API呼叫,或是搭配 Semantic Kernel 框架運作都是可以的。

但由於初始訓練成本就低,在API費用(成本)上有著一定程度的競爭力。

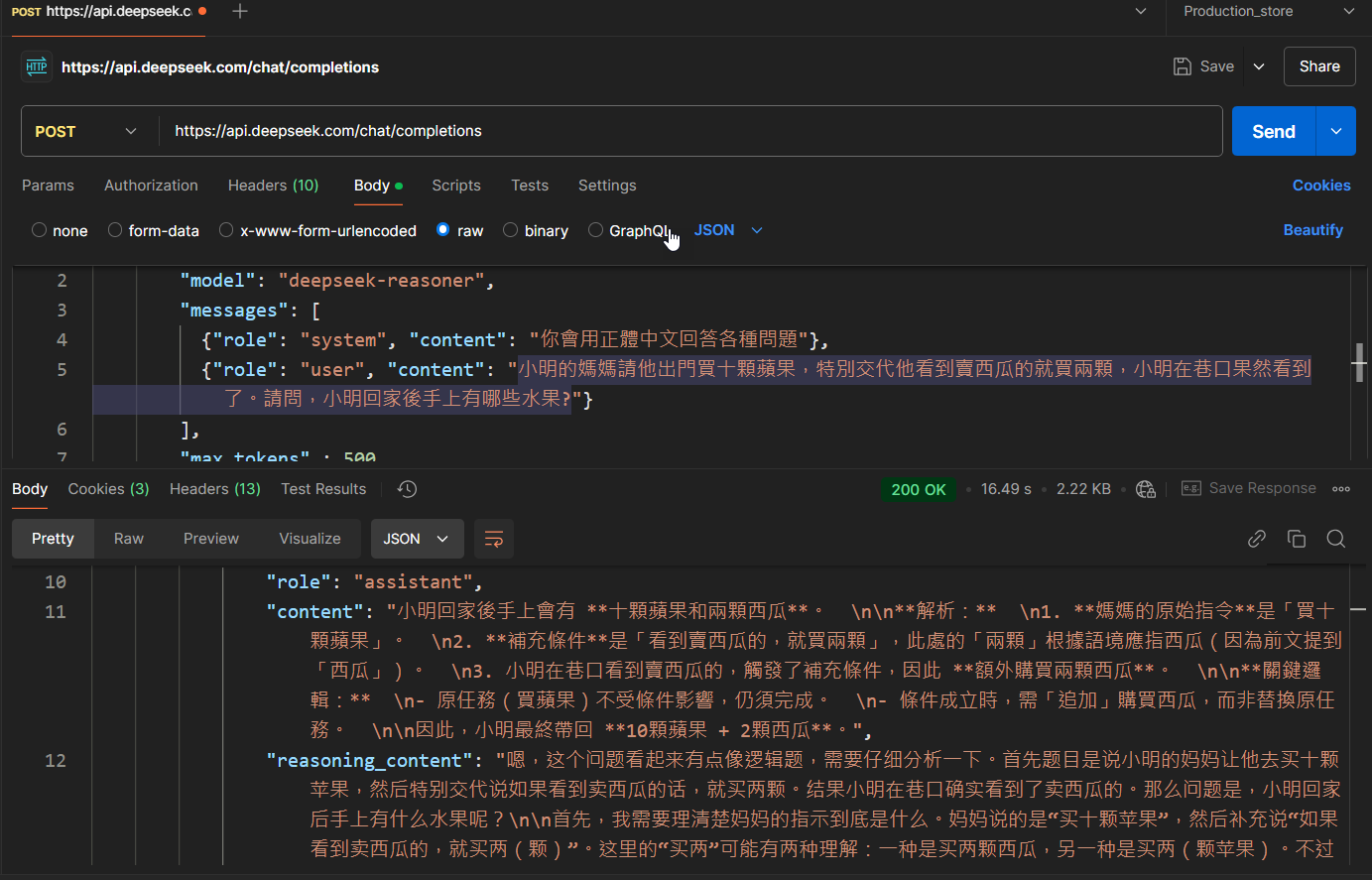

對標 OpenAI o1 的 模型 – R1

上圖是採用 R1 模型在具有思維鍊的狀況下呼叫API回覆問題的方式,只需要將 model 從 deepseek-chat 改為 deepseek-reasoner 即可。

而對標於 4o 的 V3 模型,除了呼叫方式完全相同外,也支援 JSON-Mode 和 Function Calling 等功能。

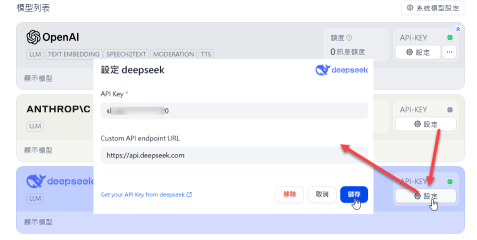

如果有在使用 Dify 的AI平台開發,你會發現上面也有直接支援:

總的來說,透過API使用 V3 與 R1 大致上你可以預期與 OpenAI API 達到類似的輸出結果,目前不管是速度還是正確性,大約都屬於可以接受的範圍。但你知道的,使用時依舊有些 政治正確與否 的問題需要你自己注意。

由於DeepSeek R1 完全開源,允許免費的商業和學術使用,因此未來在開發 AI Agent時,針對於大語言模型的選擇,應該又會多了另一個選項,有興趣的朋友不妨試試看。

留言