在 Azure 上部署與使用 deepseek R1 model

現在,你可以在 Azure AI Foundry 上使用 deepseek R1 model 了,如果不想自己在local搭建,又不想用位於 deepseek 的伺服器,那微軟 Azure 給了你另一個選擇。

搭建好後,你將會有自己的 endpoint,可以直接透過 REST API 呼叫 ,並且擁有 Azure 上預設的內容過濾器(content filter),以確保輸出輸入的安全性。

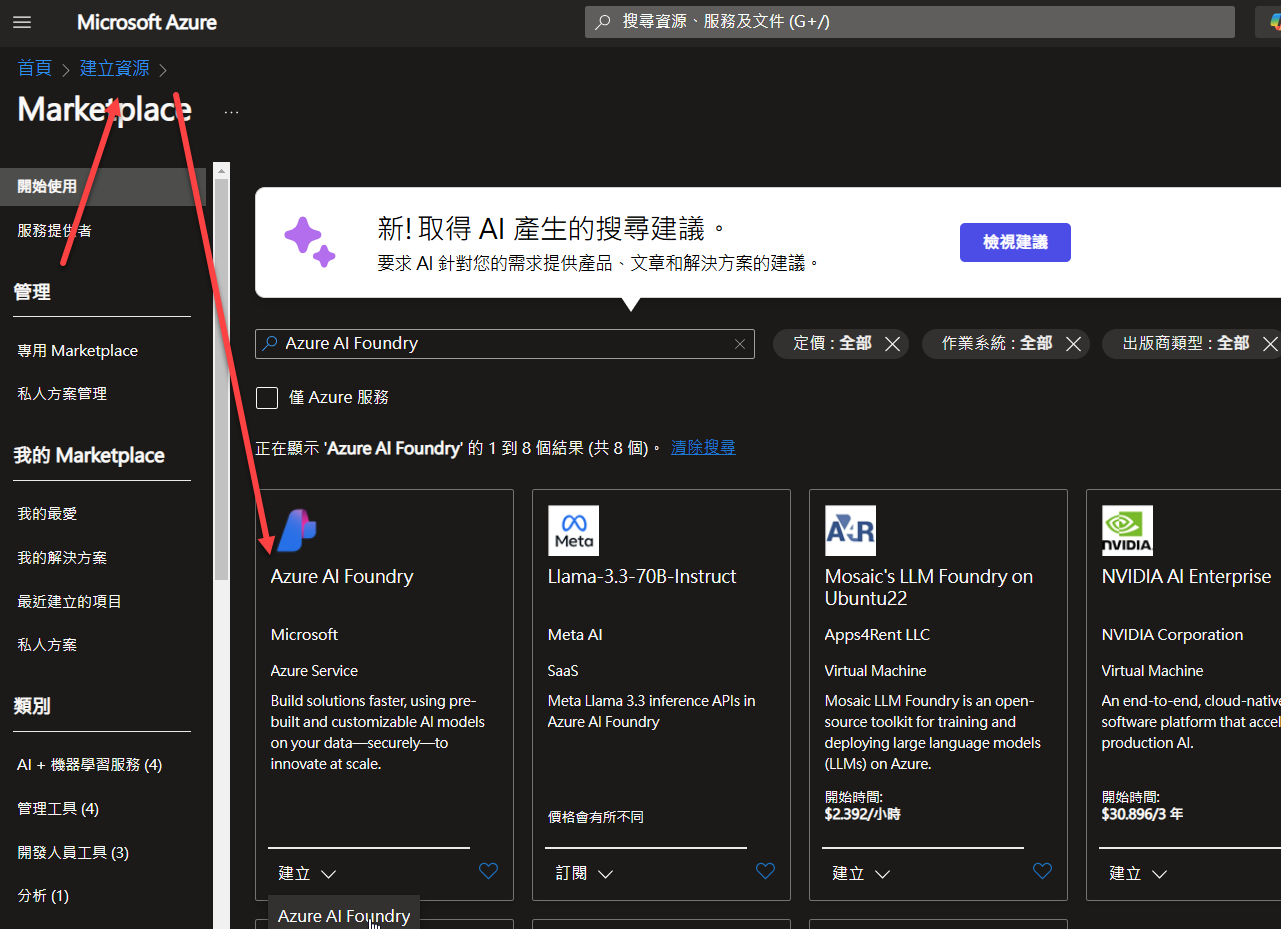

使用的方式很簡單,只需要在 Azure Portal 先建立 Azure AI Foundry 服務:

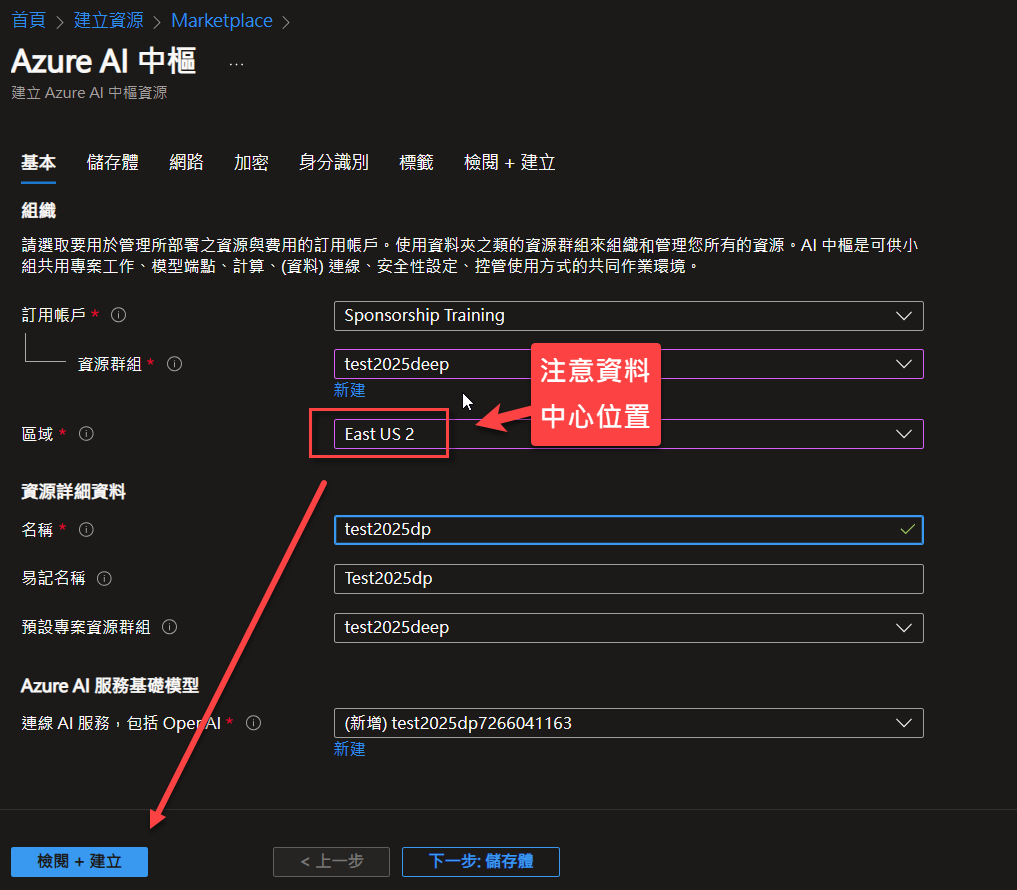

建立時稍微留意一下,由於目前 deepseek model 只有在幾個資料中心提供,因此建議你選擇 Esat US 2 資料中心作為 資源所在位置:

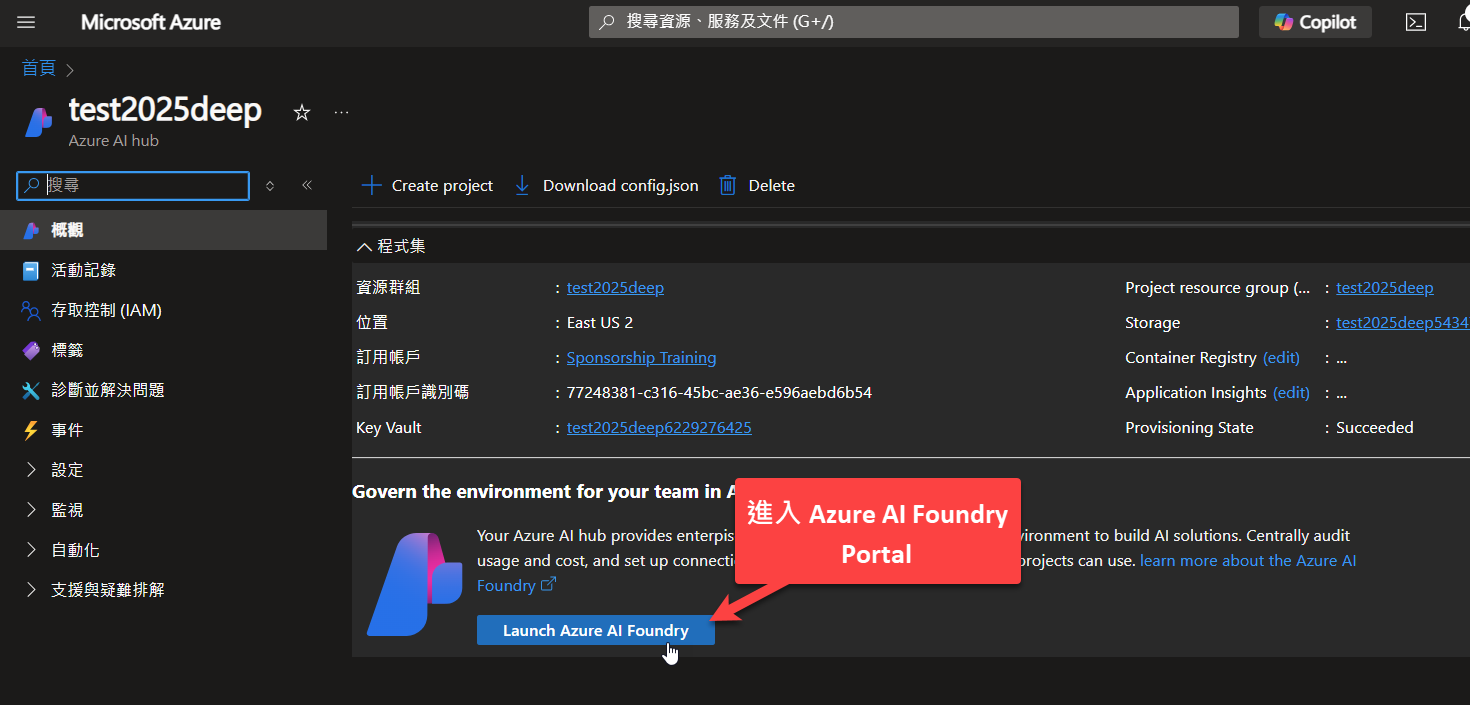

建立完成之後,進入該服務,點選左方選單的 概觀 ,進入 Azure AI Foundry Portal:

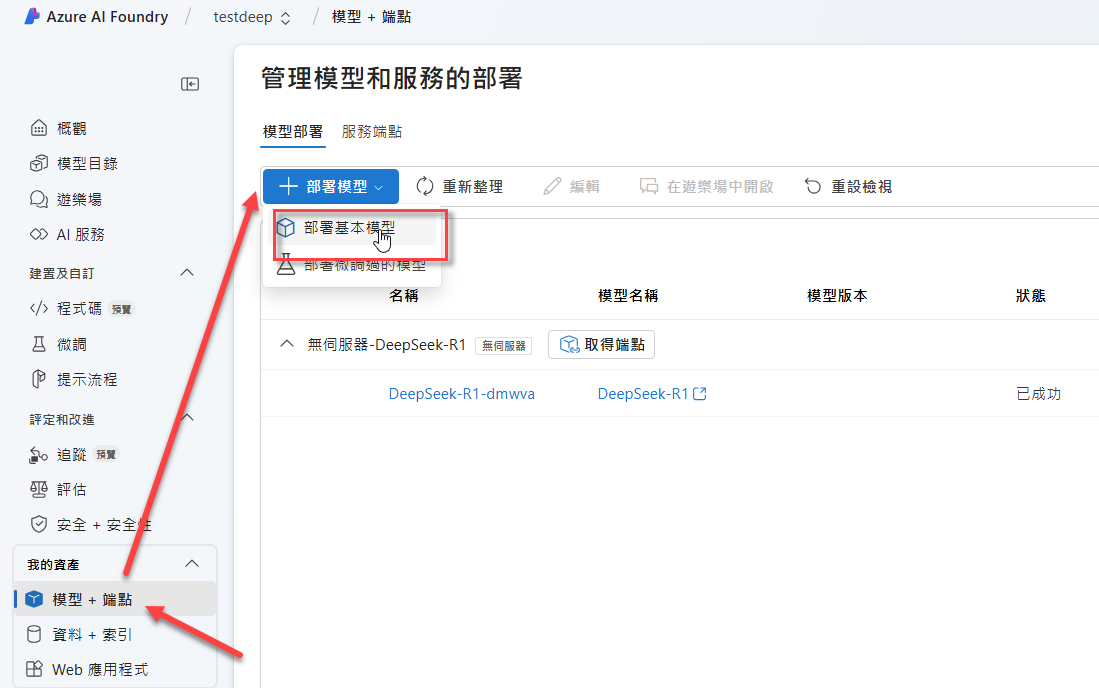

進入之後,可以在模型+端點 處部署基本模型:

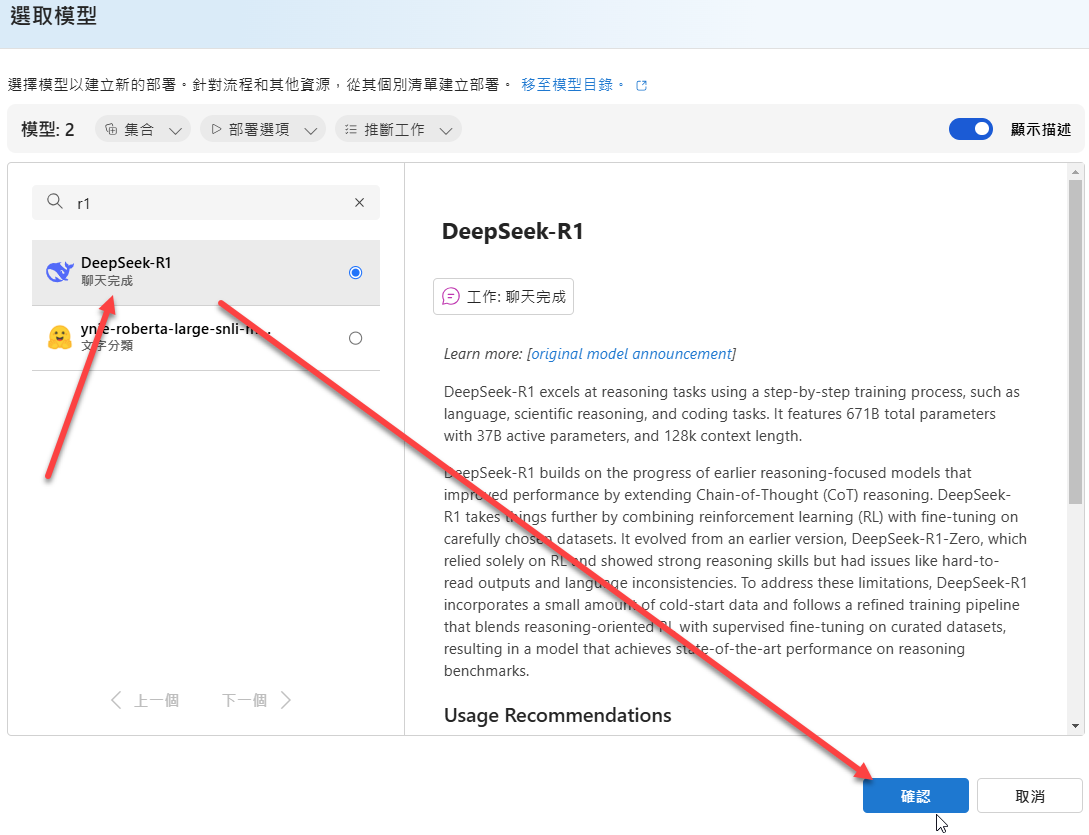

在列出的模型清單中,找到 R1:

接著確認專案和部署名稱:

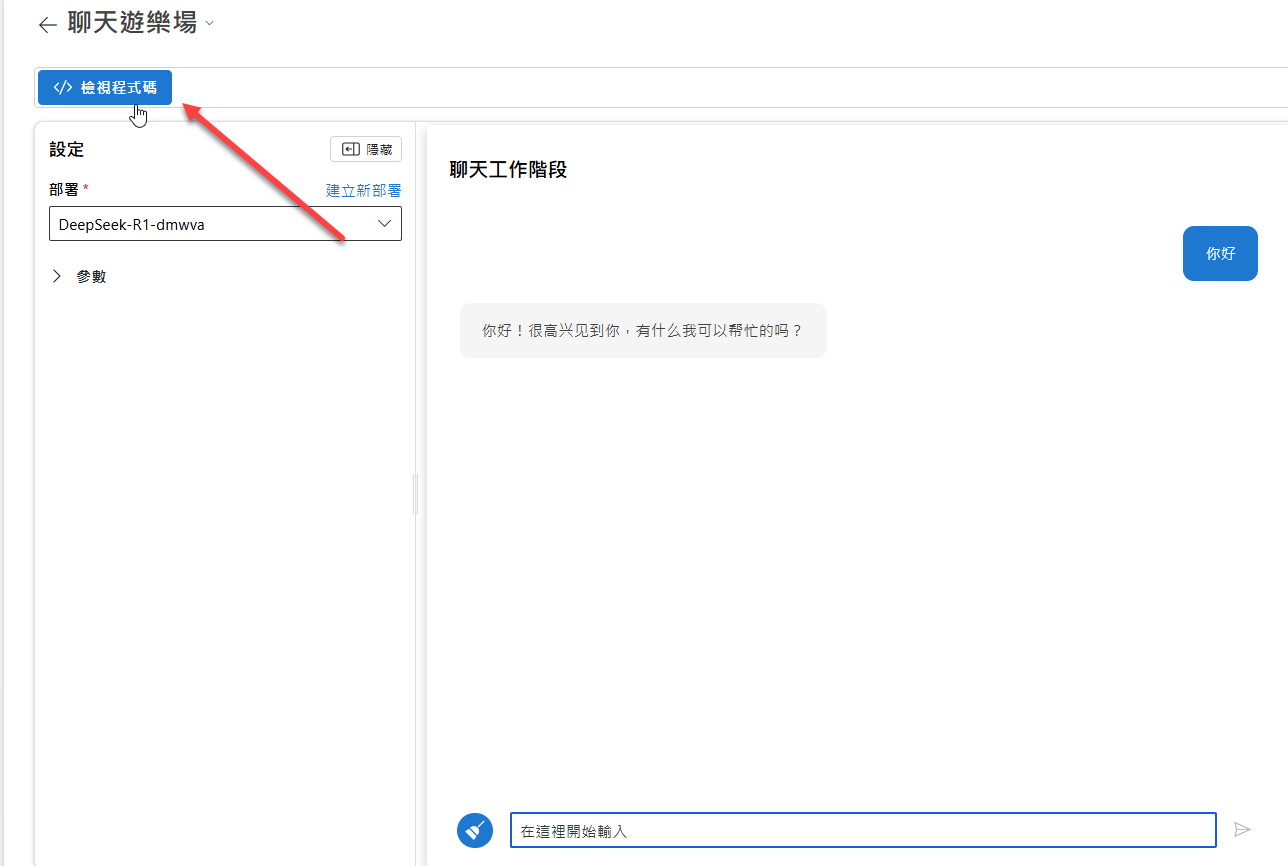

按下部署鈕即可完成部署。完成後,可在遊樂場中開啟:

接著就可以輸入文字測試:

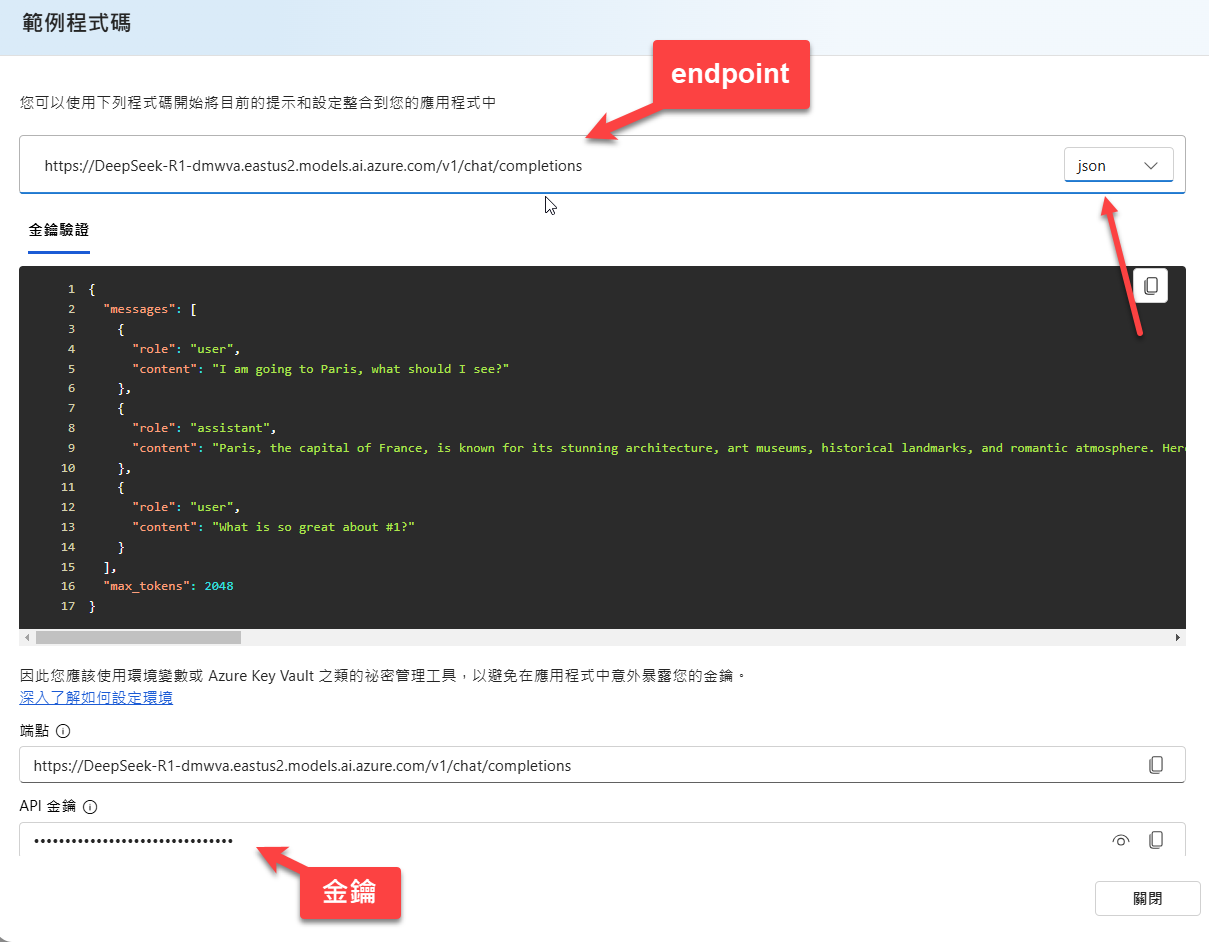

也可以從檢視程式碼中找到API呼叫方式:

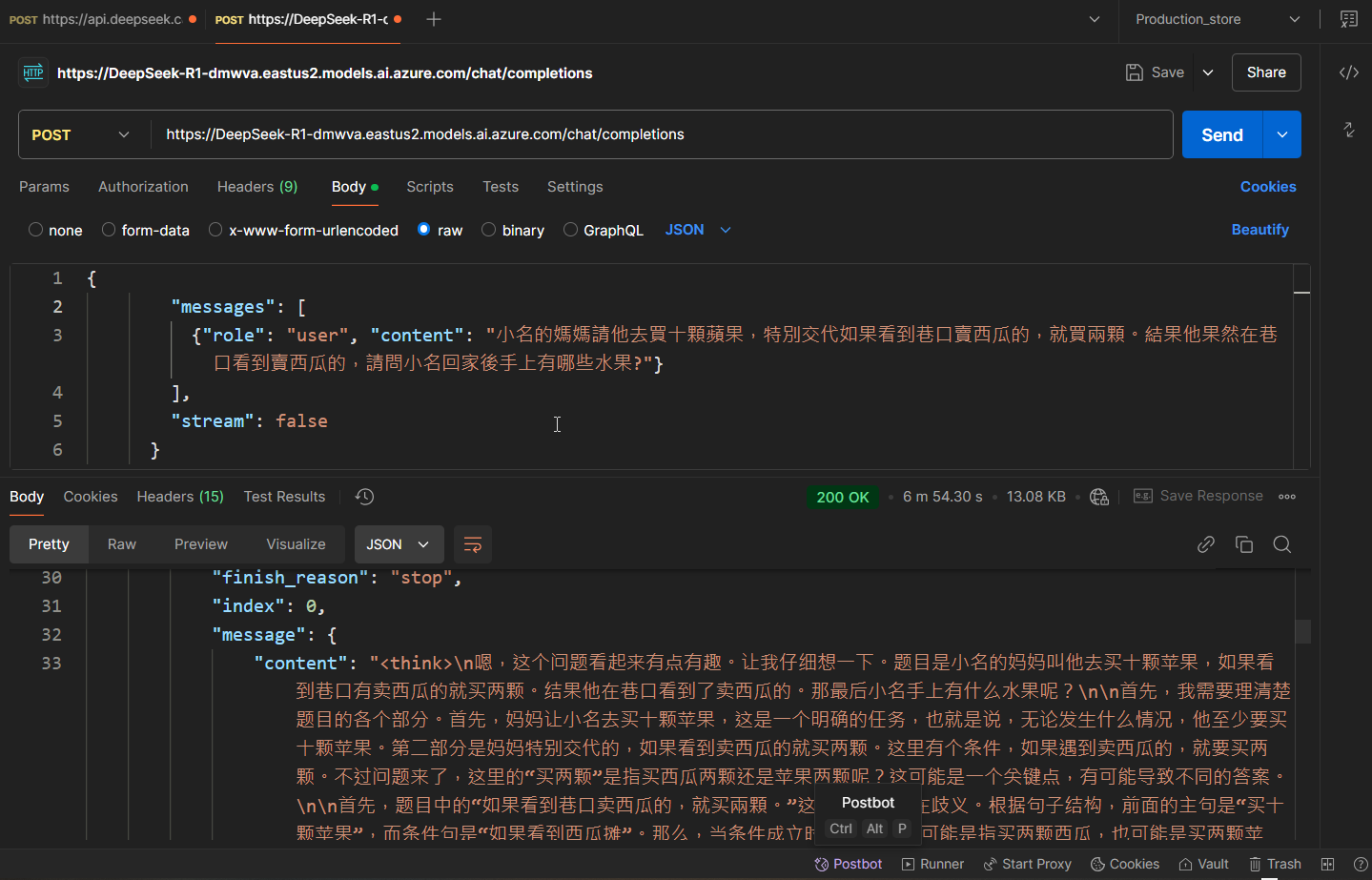

有了 endpoint 與 金鑰之後,就可以大方的透過程式碼來呼叫囉:

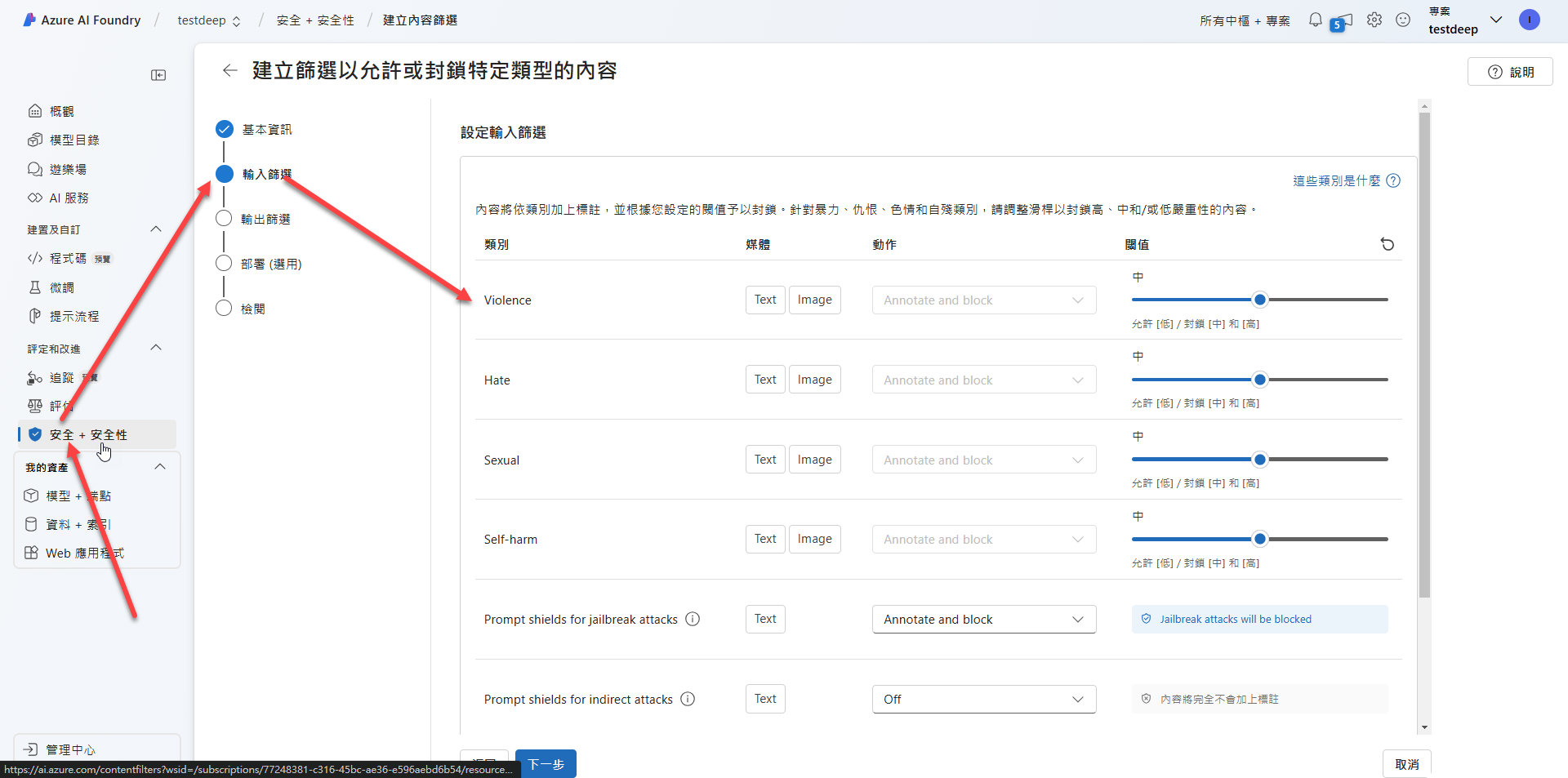

內容篩選

順帶一提,微軟的 AI Model 大多內建 content filter 來做內容篩選,因此,預設狀況下,舉凡仇恨、暴力、情色、自殘…等文字的輸入和輸出都會被過濾掉,以確保安全性,這部分如果你想要客製化調整,可以參考底下位置:

AI應用即將落地

最近很紅的 deepseek ,網路消息很多。有人覺得這模型有些貓膩,有人覺得從論文看起來,確實有不少的創新。但不管如何,他的出現都宣示著一個更便宜、更有可能讓 AI 解決方案落地的機會即將來臨。

過去GPT 4o和o1這等高階的模型,一直讓LLM應用的成本居高不下,而deepseek v3和r1的出現,一舉把推斷成本降低到1/10以下,這讓AI應用的門檻大幅降低。而蒸餾過的小模型,也可以在較低的PC環境上直接運行,這又讓AI edge 化的可能性大幅提高,2025年看來將會熱鬧非常。

留言

而是 部署模型 endpoint路徑也不太一樣